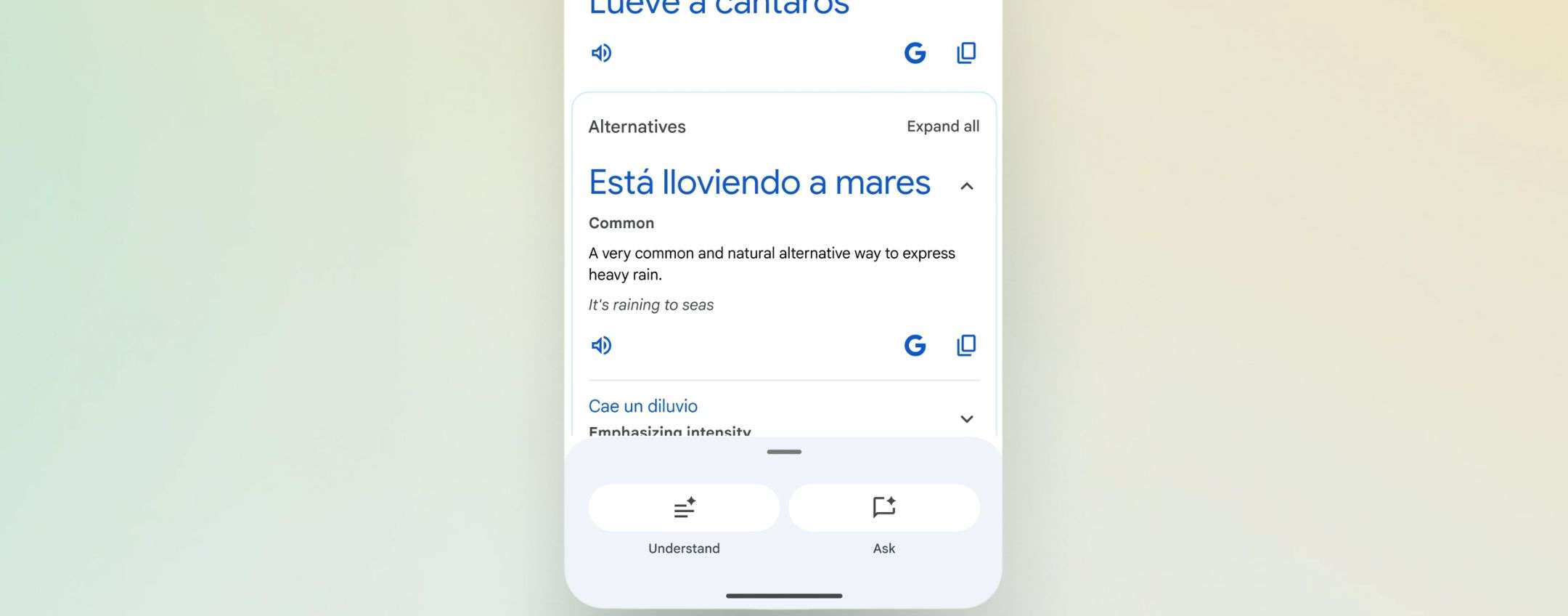

Red Hat lancia AI Inference Server: qualunque modello, su qualunque acceleratore, su qualunque cloud

Red Hat AI Inference Server punta a offrire un ambiente in cui eseguire i modelli d'IA indipendentemente da ciò che sta sotto di esso, e dunque indipendentemente da GPU o ambiente cloud